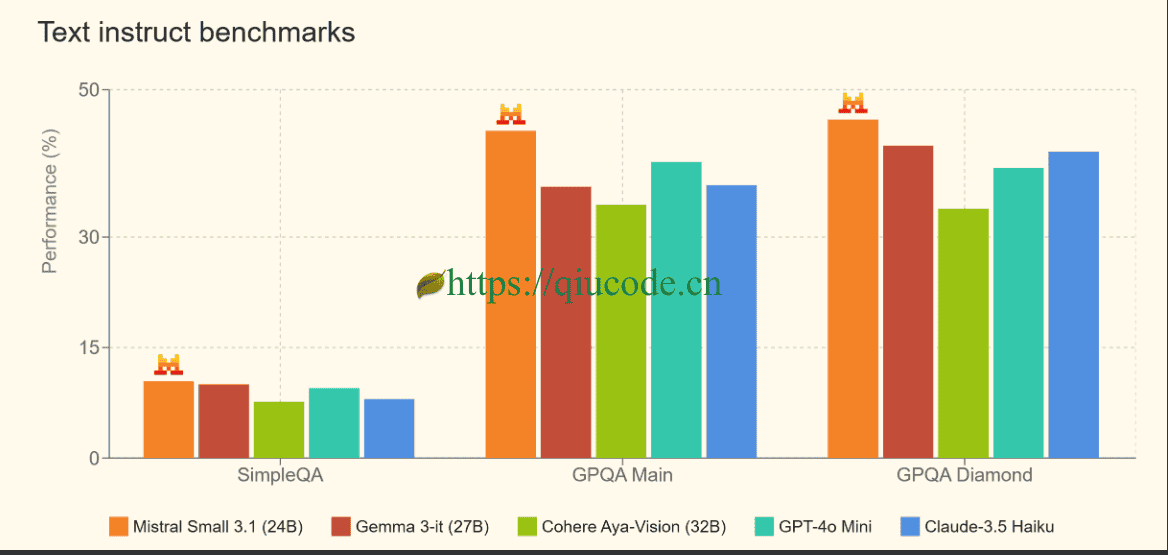

这不Gemma3刚开源出来,立马炸裂了整个“科技界”,还没等它把“热度”持续火下去,Mistral-Small3.1却再次掀起了“科技界”的热度。

Mistral-Small3.1是Mistral AI推出的240亿参数开源多模态模型,基于Transformer架构优化设计,核心特性包括:

- 多模态支持:支持文本与图像结合的任务处理,扩展了应用场景边界。

- 128k超长上下文窗口:可一次性处理长篇文档或复杂对话,显著优于前代的32k窗口。

- 高效推理引擎:采用量化技术优化推理速度,每秒处理150个token,延迟低至毫秒级,适合实时交互场景。

- 本地化部署能力:支持在RTX 4090显卡或32GB内存的Windows设备上运行,通过Ollama等工具实现轻量化部署.

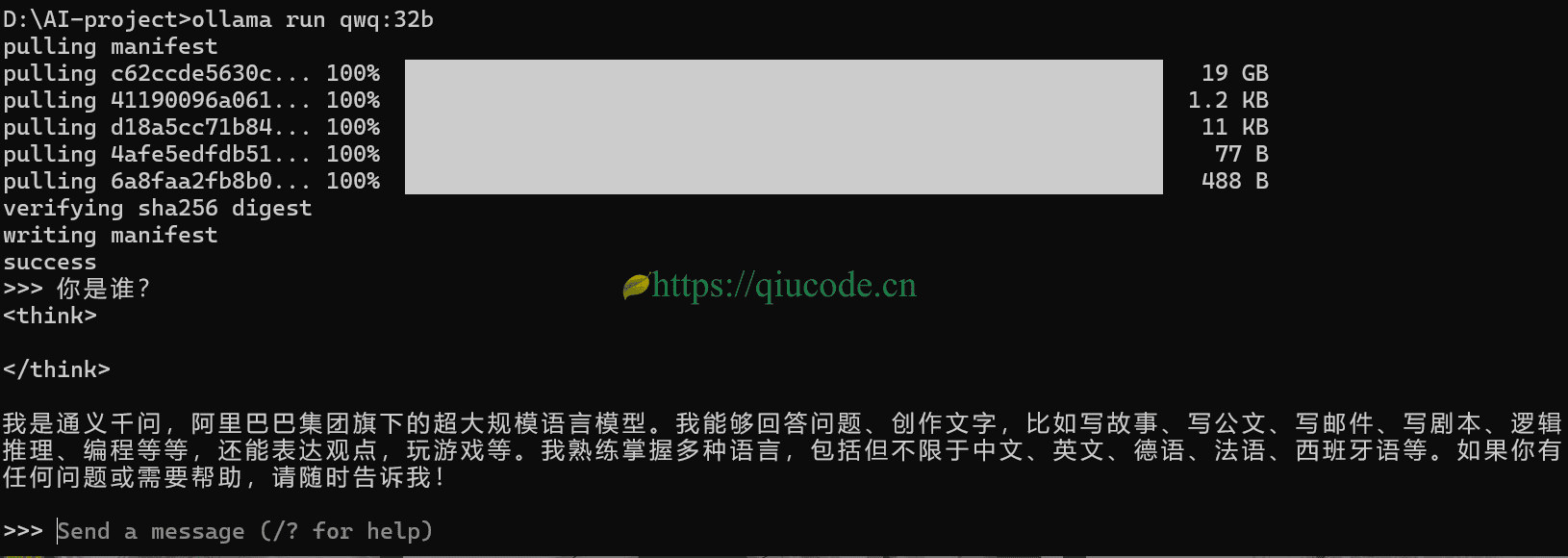

通过Ollama部署

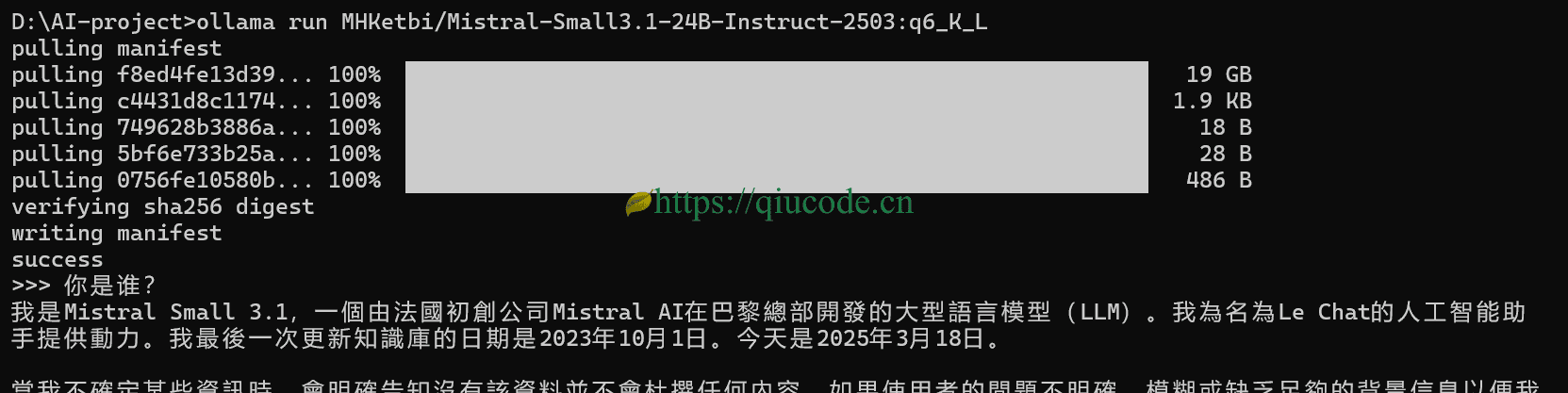

那么,接下来,我们在本地通过Ollama来部署Mistral-Small3.1。

如果你还没安装Ollama的话,那么,你可以去它的官网进行下载安装,Ollama官网。

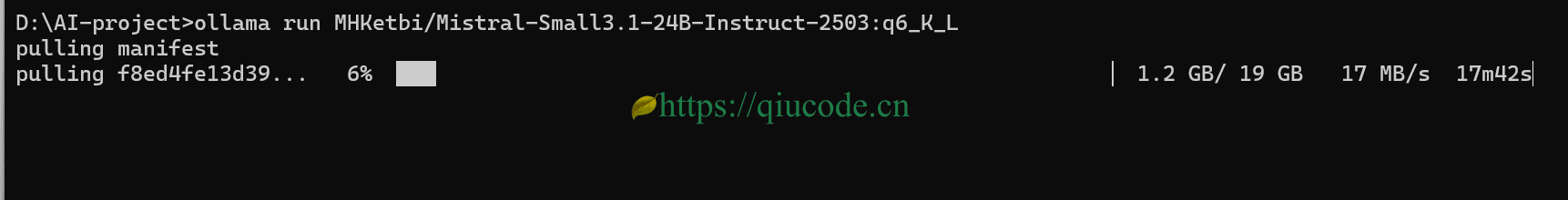

我这里选择了量化版,根据自己电脑的硬件设备来下载对应的量化版本。

拷贝命令,直接黏贴到Terminal中。

ollama run MHKetbi/Mistral-Small3.1-24B-Instruct-2503:q6_K_L

主要特性和功能

- 轻量级:

Mistral Small 3.1可以在单个RTX 4090或具有32GB RAM的Mac上运行。这使其非常适合设备上的使用情况。 - 快速响应对话帮助:非常适合虚拟助手和其他需要快速、准确响应的应用程序。

- 低延迟函数调用:能够在自动化或代理工作流程中快速执行函数

- 针对专业领域进行微调:

Mistral Small 3.1可以针对特定领域进行微调,打造精准的主题专家。这在法律咨询、医疗诊断和技术支持等领域尤其有用。 - 高级推理的基础:社区在开放的 Mistral 模型之上构建模型的方式继续给留下深刻印象。仅在过去几周,就看到了几个基于

Mistral Small 3构建的出色推理模型,例如Nous Research的DeepHermes 24B。为此,发布了Mistral Small 3.1的基础和指令检查点,以便进一步对模型进行下游定制。

如果你本地电脑硬件资源有限的话,那么是可以前往Mistral 官方平台上使用,上面是满血版【点击前往】

2025-03-15 22:06:43 +0800 +0800

2025-03-15 22:06:43 +0800 +0800 2025-03-13 20:26:43 +0800 +0800

2025-03-13 20:26:43 +0800 +0800 2025-03-10 21:26:43 +0800 +0800

2025-03-10 21:26:43 +0800 +0800 2025-03-07 21:26:43 +0800 +0800

2025-03-07 21:26:43 +0800 +0800 2025-03-05 21:26:43 +0800 +0800

2025-03-05 21:26:43 +0800 +0800