引言:当声音克隆不再需要训练

在传统语音转换技术中,用户往往需要数小时的录音数据和复杂的模型训练才能实现声音克隆。而2024年发布的Seed-VC(Speech-to-Speech Voice Conversion)技术打破了这一范式——它通过零样本学习(Zero-Shot Learning)实现即时声音克隆,仅需1-30秒的参考音频即可完成音色复制,甚至支持实时转换和歌声生成 。这项技术不仅在学术界引发关注,更在娱乐、影视、教育等领域掀起应用浪潮。

技术解析:Seed-VC的核心创新

- 零样本学习的实现原理 Seed-VC基于上下文学习(Contextual Learning)和深度神经网络,通过以下流程完成声音克隆:

- 特征提取:从源语音和目标语音中提取音高、音色、韵律等关键特征

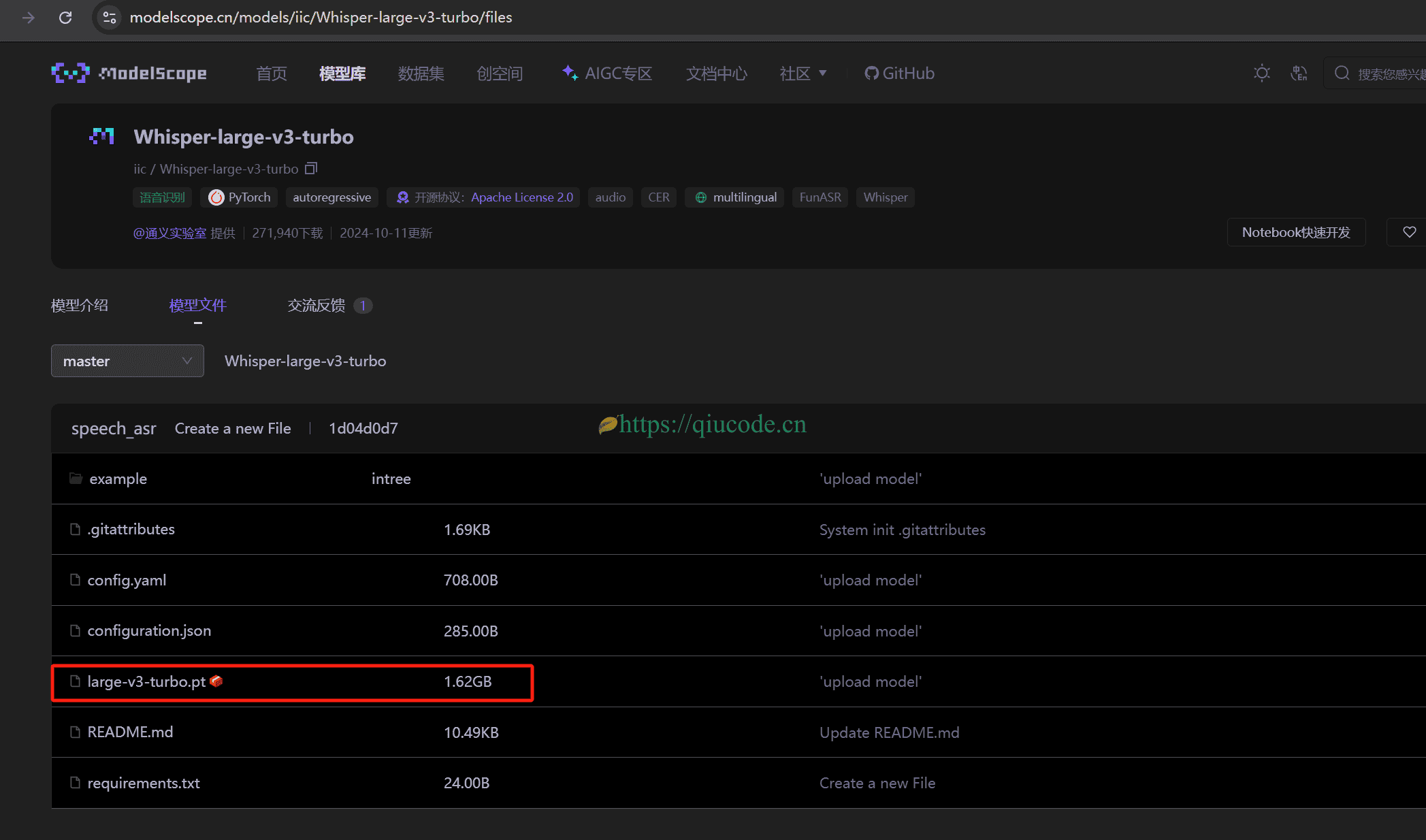

- 特征编码:利用XLSR或Whisper模型将声音编码为中间表示

- 扩散模型生成:采用HiFT或BigVGAN声码器合成高质量语音波形,支持25-100步的扩散过程平衡速度与质量这种架构无需预训练特定音色模型,真正实现“即插即用”

- 突破性功能:实时与歌声转换

- 300ms实时处理:通过优化算法延迟和设备侧处理,支持在线会议、直播等场景的即时变声

- 歌声合成黑科技:将说话语音转换为歌声时,保留原音色特征并自动调整音高,解决传统SVC技术中音色失真问题

- 性能优势 在客观评估中,Seed-VC在语音清晰度(PESQ 4.32)和相似度(SIM 0.89)上显著超越OpenVoice、CosyVoice等模型,甚至优于部分需训练的模型(如So-VITS 4.0)

应用场景:声音的无限可能

- 影视与娱乐

- 为动画角色快速生成定制音色(如用30秒明星语音生成角色配音)

- 直播中实时切换音色,创造虚拟主播的多样化声线

- 音乐创作

- 将未受过声乐训练者的语音转换为专业级歌声,支持半音调校以适配背景音乐

- 案例演示:用户通过剪映分离背景音后,用Seed-VC将干声转换为数字人演唱版本

- 教育与医疗

- 语言学习中模拟不同口音发音,例如中文方言到标准普通话的即时转换。

- 为失声患者复刻个性化语音,保留情感表达特征。

实践指南:如何快速上手

部署方式

- 小白友好型:通过

Hugging Face的Gradio网页界面直接上传音频 - 开发者模式:命令行工具支持参数微调,如设置扩散步数(

--diffusion-steps)控制生成质量。

- 小白友好型:通过

模型选择建议

模型版本 适用场景 延迟 参数量 seed-uvit-tat-xlsr-tiny 实时语音转换 <400ms 25M seed-uvit-whisper-base 高保真歌声合成 1-2s 200M 进阶技巧

- 使用

--semi-tone-shift调整音高适配歌曲调性 - 开启

auto-f0-adjust自动对齐说话与歌唱音高

- 使用

行业影响与未来展望

Seed-VC的出现标志着语音合成技术从“专用模型”向“通用基座”的转型。其自定义微调功能(每位说话人仅需1条语音)让个性化声音克隆门槛大幅降低 。据预测,到2030年,语音转换市场将突破10亿美元,而零样本技术将成为主流 。

Seed-VC不仅是一项技术突破,更是一场关于声音表达的革命。它让每个人都能低成本拥有“声音分身”,重新定义了创作、沟通与身份表达的边界。正如开发者所言:“我们的目标是让任何声音都能被自由塑造,就像文字一样。”

本地部署

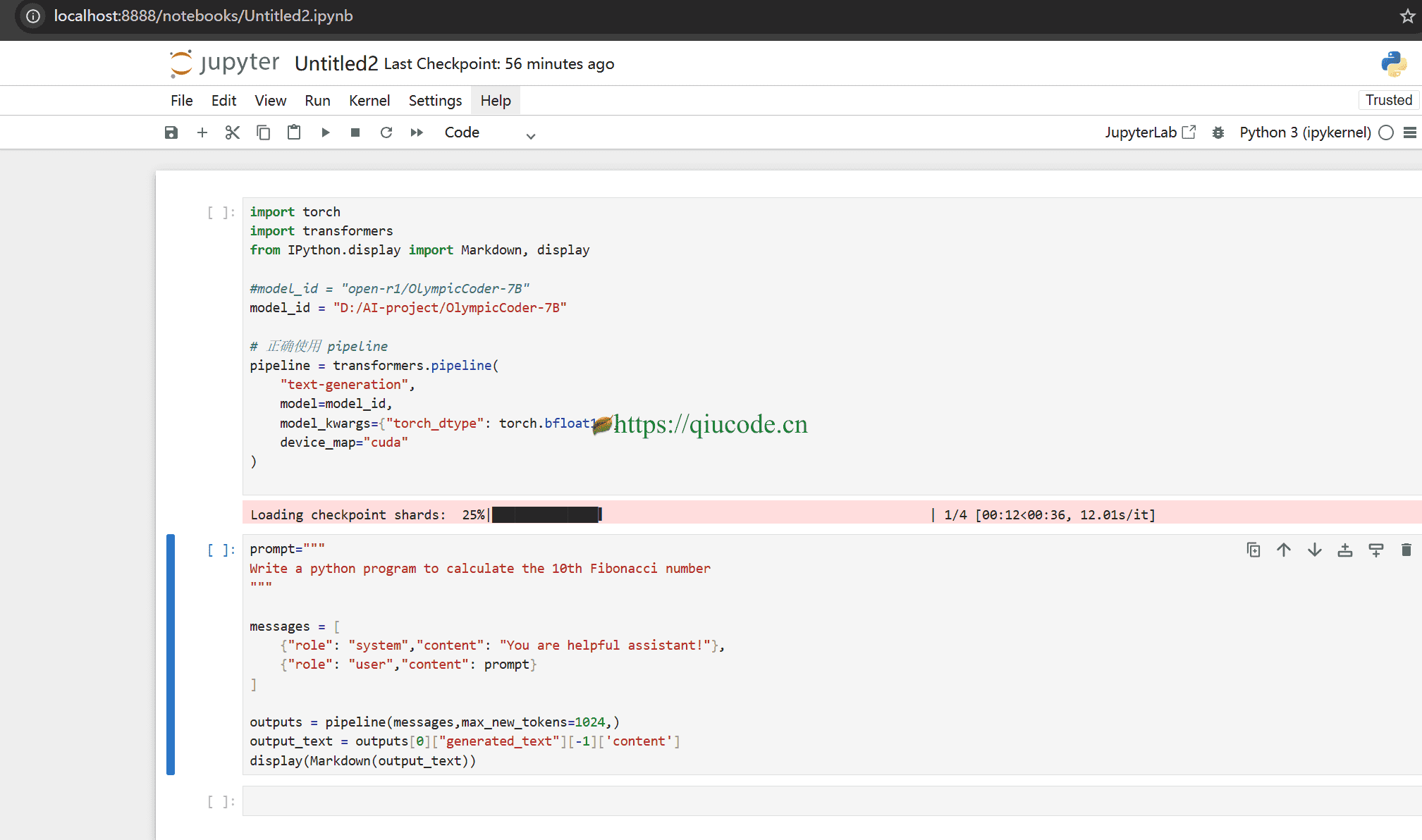

我依旧使用python3自带的venv模块来构建python虚拟环境。

python -m venv seed-vc-v2-env

cd seed-vc-v2-env/Scripts

activate

之后,我们克隆Seed-VC推理代码。

git clone https://github.com/Plachtaa/seed-vc.git

安装与你电脑CUDA版本匹配的torch。

pip3 install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu124

由于我们安装了torch,所以我们在执行pip install -r requirements.txt之前,得先修改这个文件,删除torch相关的。

修改完并保存它,随后在命令行执行pip install -r requirements.txt。

运行

等所有依赖库都安装妥当后,我们就可以运行Seed-VC项目了。

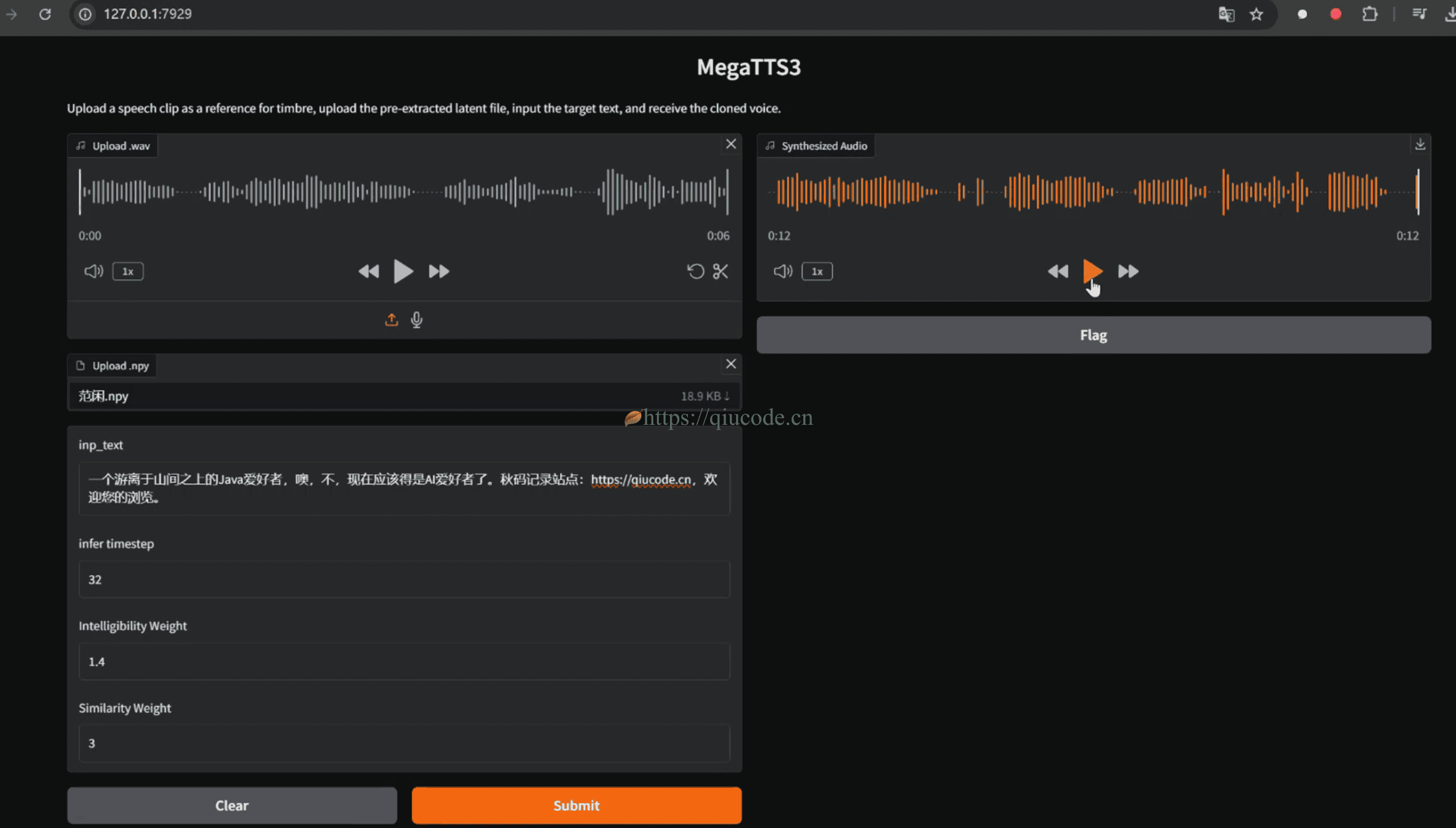

语音转换 Web UI:

python app_vc.py --checkpoint <path-to-checkpoint> --config <path-to-config> --fp16 True

checkpoint模型检查点路径,若为空将自动下载默认模型 (seed-uvit-whisper-small-wavenet)config模型配置文件路径,若为空将自动下载默认配置

歌声转换 Web UI:

python app_svc.py --checkpoint <path-to-checkpoint> --config <path-to-config>

checkpoint模型检查点路径,若为空将自动下载默认模型 (seed-uvit-whisper-base)config模型配置文件路径,若为空将自动下载默认配置

集成 Web UI:

python app.py

此命令将仅加载预训练模型进行零样本推理。要使用自定义检查点,请按上述步骤运行 app_vc.py 或 app_svc.py。

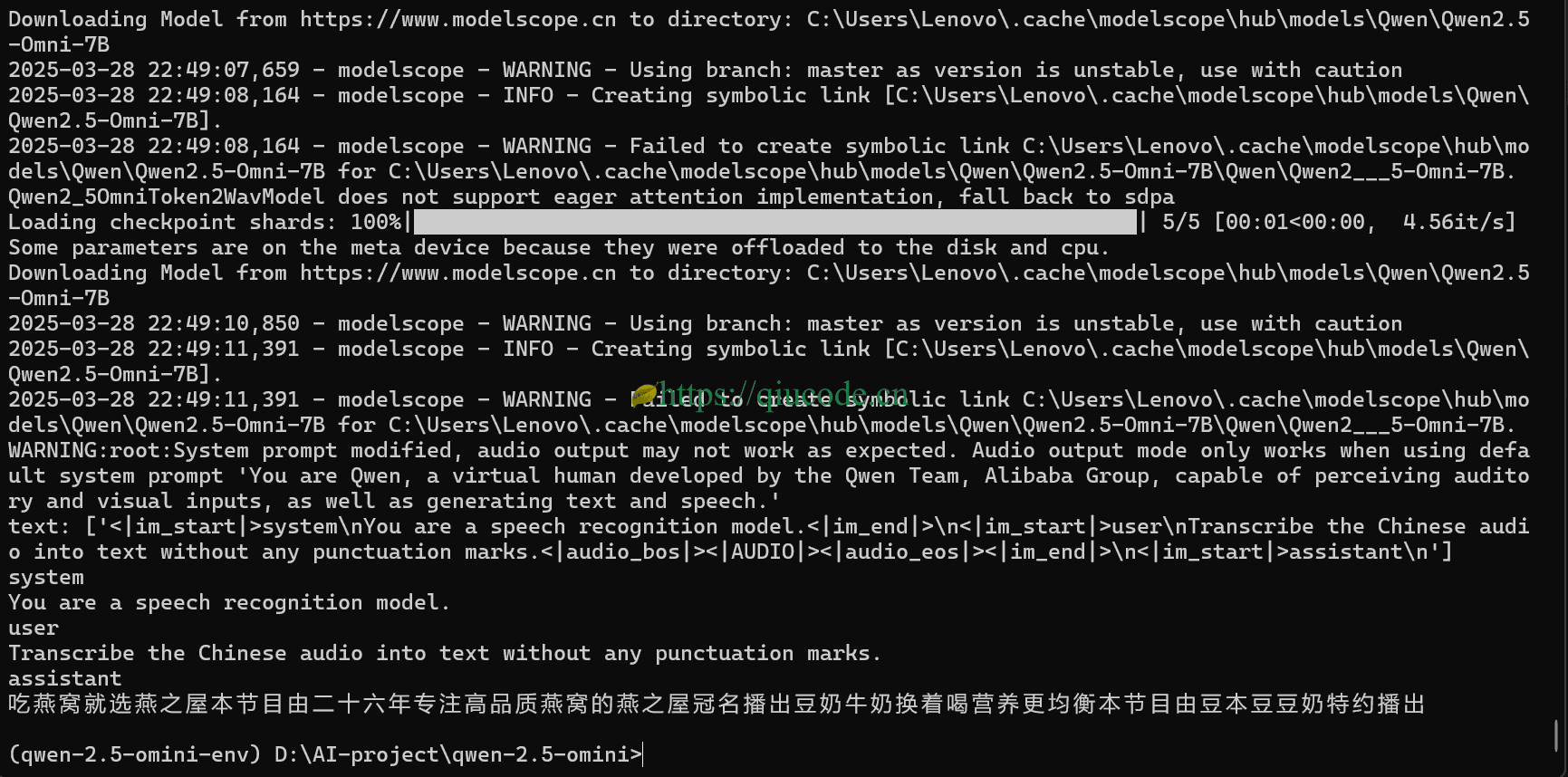

实时语音转换 GUI:

python real-time-gui.py --checkpoint-path <path-to-checkpoint> --config-path <path-to-config>

checkpoint模型检查点路径,若为空将自动下载默认模型 (seed-uvit-tat-xlsr-tiny)config模型配置文件路径,若为空将自动下载默认配置

重要提示: 强烈建议使用 GPU 进行实时语音转换。 在 NVIDIA RTX 3060 笔记本 GPU 上进行了一些性能测试,结果和推荐参数设置如下:

| 模型配置 | 扩散步数 | Inference CFG Rate | 最大prompt长度 | 每块时间 (s) | 交叉淡化长度 (s) | 额外上下文(左)(s) | 额外上下文(右)(s) | 延迟 (ms) | 每块推理时间 (ms) |

|---|---|---|---|---|---|---|---|---|---|

| seed-uvit-xlsr-tiny | 10 | 0.7 | 3.0 | 0.18s | 0.04s | 2.5s | 0.02s | 430ms | 150ms |

你可以根据设备性能调整 GUI 中的参数,只要推理时间小于块时间,语音转换流就可以正常工作。 注意,如果你正在运行其他占用 GPU 的任务(如游戏、看视频),推理速度可能会下降。

实时转换界面的参数说明:

Diffusion Steps是扩散步数,推荐实时转换设置为4~10;Inference CFG Rate是classifier free guidance rate,默认0.7,设置为0.0可以获得1.5x的加速;Max Prompt Length是最大音频提示长度,设置为较低值可以加快推理速度,但可能会降低与提示语音的相似度;Block Time是每块时间,值越高延迟越高,该值必须大于每块推理时间,根据硬件条件设置;Crossfade Length是交叉淡化长度,通常不需要更改;Extra context (left)是推理的额外上下文,设置为较高值可以增加稳定性,但会增加每块推理时间;Extra context (right)是推理的额外上下文,设置为较高值可以增加稳定性,但会增加每块推理时间以及延迟;

算法延迟大约为 Block Time * 2 + Extra context (right),设备侧延迟通常为100ms左右。总体延迟为两者之和。

你可以使用 VB-CABLE 将变声器输出映射到一个虚拟麦克风上,以便其它应用读取.

然后在浏览器中打开 http://localhost:7860/ 使用 Web 界面。

2025-04-10 23:02:43 +0800 +0800

2025-04-10 23:02:43 +0800 +0800 2025-04-01 23:02:43 +0800 +0800

2025-04-01 23:02:43 +0800 +0800 2025-03-28 22:02:43 +0800 +0800

2025-03-28 22:02:43 +0800 +0800 2025-03-25 22:02:43 +0800 +0800

2025-03-25 22:02:43 +0800 +0800 2025-03-19 22:06:43 +0800 +0800

2025-03-19 22:06:43 +0800 +0800